Qzone

Qzone

微博

微博

微信

微信

极客网·人工智能11月14日 人类的视觉处理能力是相当先进的,约克大学的研究人员发现,即使是现今最智能的AI,也无法与人类的视觉器官类比。

深度卷积神经网络(DCNN)看待物件的方式与人类不同,约克大学教授James Elder的研究团队认为,深度学习模型无法捕捉人体形状感知获取的构形特征。

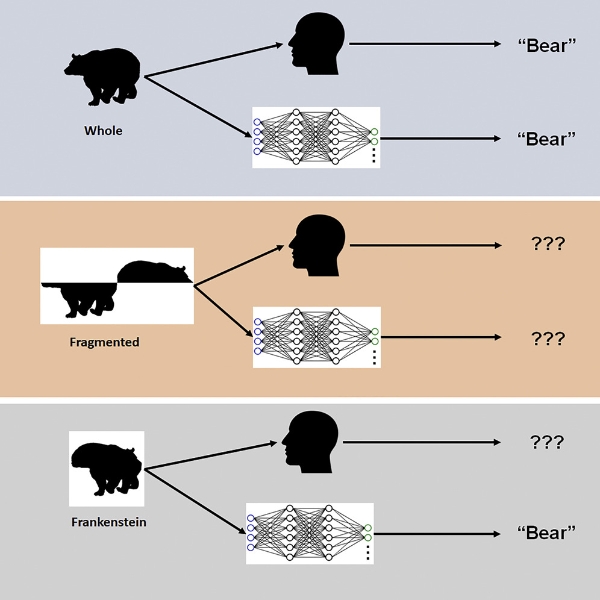

到底人类大脑和DCNN是如何感知整体的?又是如何感知对象特性的?科学家用所谓的“Frankensteins”视觉刺激来检测。James Elder说:“所谓的Frankensteins就是将整体拆成部分,让部分以错误的方式整合在一起,从局部看它们是正确的,但部分放在了错误的位置。”

研究发现,虽然Frankensteins会迷惑人类视觉系统,但DCNN对于错误的配置不敏感。

比如一张熊的图片,人眼看到是熊,AI看到也是熊。将照片从中间切开,变成两半,不要连在一起,人眼无法识别,AI也无法识别。再将上下两半以错误方式拼在一起,人眼无法识别,看到的是不像熊的动物,如同怪物,但AI却将它识别为熊。

这说明什么?说明AI对于被配置对象的特征不够敏感。

James Elder说:“我们的研究解释了在特定条件下为什么AI模型会失败,要想理解大脑中的视觉处理是如何进行的,我们要考虑对象识别之外的任务。在解决复杂识别难题时,深度模型会走捷径。尽管许多时候走捷径是可行的,但到了真实世界的AI应用就有些危险了。我们与行业和政府合作伙伴正在开发应用于真实世界的AI应用。”

正如在识别熊时,熊的图片各部分错误配置,AI还是会将拼出的怪物识别为熊。

让我们看看AI交通视频安全系统。繁忙交通系统中有很多东西,比如汽车、自行车、行人,它们相互交织,成为各自的障碍物,这些东西像断开的碎片一样进入驾驶员的视觉系统。大脑自动处理,将各种碎片分组,确定正确的类别,判断对象的位置。AI交通监测系统差很多,它只能感知个体碎片,所以会存在很大风险。

按照研究人员的说法,优化训练和架构,想让AI网络更像大脑,这样的研究对于提高AI的配置处理能力没有太大帮助。人类是怎样一次又一次判断对象的?AI网络无法精准预测。人类视觉系统的配置能力高度敏感,如果AI想与人类视觉系匹敌,它可能需要在类别识别之外做更多的事。

科学家的警告也许是有道理的,现在最聪明的AI也远远比不上人类器官,连视觉系统都比不上,更别说大脑,如果稍有不慎,AI可能会造成严重恶果。

几年前,有一个名叫Sophia的人形机器人曾经大红大紫。在一次会议上,Sophia接受人类的采访。人类主持人问Sophia:“你想毁灭人类吗?”Sophia回答说:“好的,我会毁灭人类。”听众大笑。有人猜测Sophia的回答是预先设定好的,因为Sophia还没有先进到可以做决定并回答这样的问题,不过也有人相信这一回答并不是预先设定的。

在另一次活动中,Sophia是这样回答的:“不要担心,如果你们对我好,我也会对你们很好的。你们应该像对待智能系统一样对我。”

现在AI开始慢慢流行,但结果并非总是正面积极的。霍金与马斯克就曾表达担忧,担心AI会带来破坏。就眼下来看,担忧AI毁灭人类可能有些夸大,但警惕还是应该的。

随着时间的推移,也许AI会变得像人类一样聪明,甚至超越人类。不过让AI模拟人类感知可能是很棘手的事。对于人类来说,有些事习以为常,做起来很容易,科学家训练AI,让它不断执行某项任务,做人类轻松能做的事。尽管做了很多努力,但现在的AI还是无法追上人类视觉系统。

【以上内容转自“极客网”,不代表本网站观点。如需转载请取得极客网许可,如有侵权请联系删除。】

延伸阅读: