Qzone

Qzone

微博

微博

微信

微信

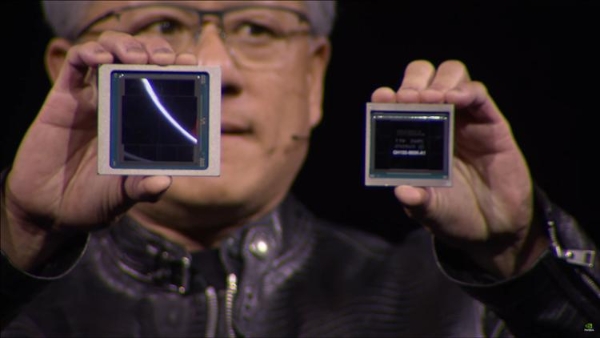

在这个星球上,英伟达毫无疑问是如今的AI之王,其推出的H100已经被众多科技企业抢购,而英伟达的营收和利润也是节节攀升。但是在这个算力决定效率的今天,英伟达H100计算卡的算力还远远不够,尤其是像Sora这样的文生视频的模型出来,更是对计算卡的算力提出了更高的要求,于是英伟达也适时地推出了下一代GPU,在AI性能上有着突飞勐进的进步,可以说拉了竞争对手整整一代。

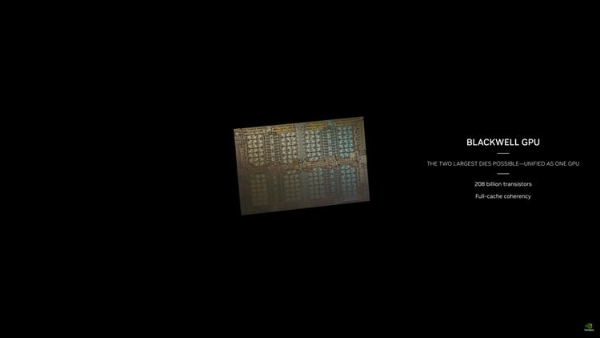

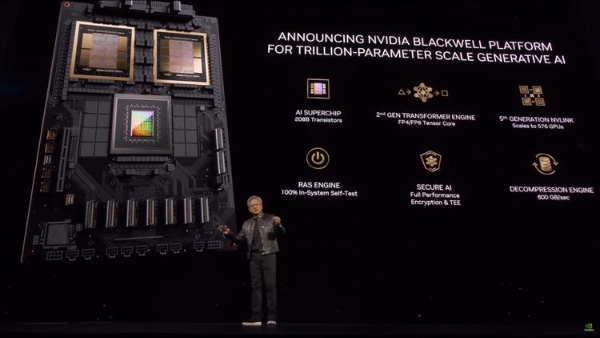

英伟达在今天凌晨举办GTC技术大会,在大会上,英伟达正式宣布了Blackwell架构,同时也表示B200芯片将会是首款基于Blackwell打造的GPU。首先是制程架构,没想到已经不差钱的英伟达并没有采用台积电的3nm制程架构,而是继续采用4nm制程,而B200则是基于两颗芯片打造而成,总共拥有2080亿个晶体管,借助NVlink 5.0进行数据传输,而NVLink 5.0在B200上可以实现1.8TB/s的数据传输,是上代的两倍,而NVLink 5.0的理论速度可以达到10TB/s。

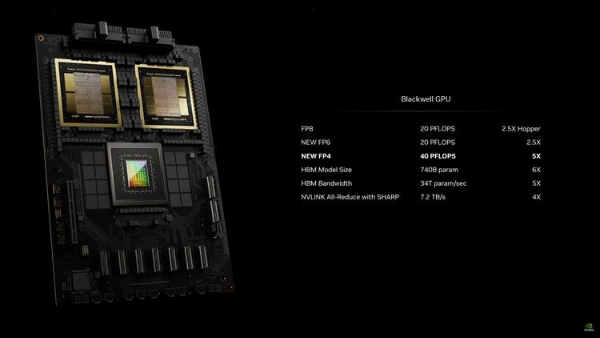

毫无疑问B200芯片最大的特点就在于其强大的AI算力,老黄表示B200芯片的AI算力达到了20PFlops,远超现在的H100的4PFLOPs,相当于是现在的5倍性能,从而可以让AI厂商训练更加复杂的模型,但是算传统的算力,B200中单个芯片比H100高出25%,也就是说传统算力B200是H100的2.5倍。

此外老黄还发布了基于两颗B200芯片以及Grace CPU打造的AI超算GB200,训练与推理LLM的性能比上代提升了30倍,简直就是黑科技。英伟达表示按照AI厂商训练一个1.8万亿参数的大语言模型计算,原本需要8000块Hooper GPU,同时功耗达到了15兆瓦,而现在厂商仅需2000块GPU,功耗大约是4兆瓦,而在GPT-3的训练中,GB200的训练速度是H100的4倍,而推理速度则是H100的7倍。

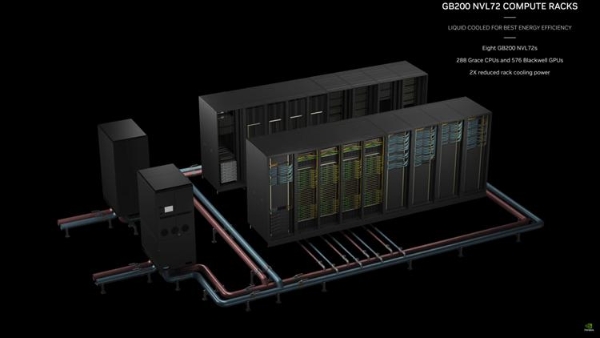

这还只是AI超算的一小部分,英伟达针对企业以及高性能计算用户推出了GB200 NVL72服务器,最多拥有36个CPU和72个Blackwell GPU,以及专门定制的水冷解决方案,最高提供720PFLOPs的AI训练性能以及1440FLOPs的推理性能,此外一个机架上还包括18个GB200芯片以及9个NVLink交换机,最高实现27万亿个参数模型的训练,要知道现在的GPT-4模型训练参数大约为1.7万亿个,未来将会为AI带来更大的可能。

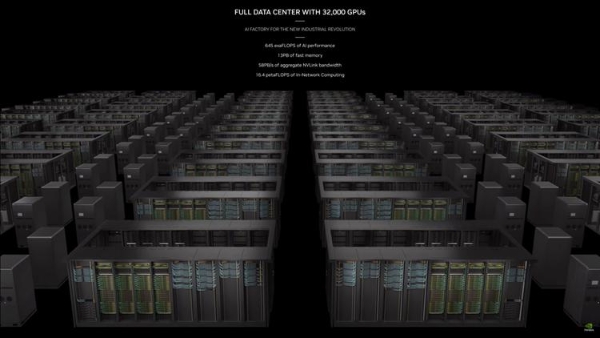

当然GB200 NVL72服务器并不是Blackwell的极限,英伟达还将推出DGX GB200这样的服务器集群,共有八个GB200 NVL72服务器,拥有288个CPU,576个GPU,内存容量达到了240TB,FP4算力更是达到了11.5EFLOPs,实在是太过于恐怖,甚至英伟达还表示如果你觉得算力还不够,未来英伟达DGX还可以进行不断地扩展,借助Quantum-X800 InfiniBand以太网实现数万颗GPU的互联互通,让AI训练性能达到前所未有的高度。

目前包括微软、谷歌、亚马逊已经表示将大量采购英伟达的新一代GB200服务器用于AI训练。目前英伟达还没有公布GB200的具体价格,不过很有可能价格达到了十几万,而且现在这种AI神器完全就是买方市场,供不应求,看起来英伟达的营收还将在2024年创下新高,毕竟在AI领域,老黄的领先程度实在是太大了。

【以上内容转自“热点科技网”,不代表本网站观点。 如需转载请取得热点科技网许可,如有侵权请联系删除。】

延伸阅读: